SSIM

结构相似性指数(structural similarity index,SSIM)是一种用于量化两幅图像间的结构相似性的指标。与L2损失函数不同,SSIM仿照人类的视觉系统(Human Visual System,HVS)实现了结构相似性的有关理论,对图像的局部结构变化的感知敏感。SSIM从亮度、对比度以及结构量化图像的属性,用均值估计亮度,方差估计对比度,协方差估计结构相似程度。SSIM值的范围为0至1,越大代表图像越相似。如果两张图片完全一样时,SSIM值为1。

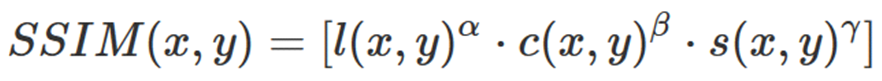

给定x,y两张图片,两者之间的照明度(luminance)、对比度 (contrast) 和结构 (structure)分别如下公式所示:

定义:

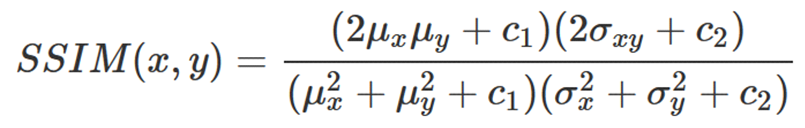

令α,β,γ均为1因此,SSIM的表达式为:

其中,μx是x的平均值,σ2x是x的方差,μy是y的平均值,σ2y是y的方差,σxy是x 和 y 的协方差,c1=(k1L)2,c2=(k2L)2是两个用于维持稳定的常数,避免出现除零的情况,L 为像素值的范围,表示B-bit的图像的L值为2B-1。一般情况下,k1=0.01,k2=0.03

PSNR

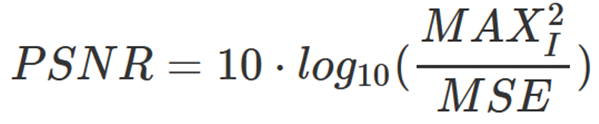

峰值信噪比(Peak Signal to Noise Ratio, PSNR)是一种评价图像质量的度量标准。因为PSNR值具有局限性,所以它只是衡量最大值信号和背景噪音之间的图像质量参考值。PSNR的单位为dB,其值越大,图像失真越少。一般来说,PSNR高于40dB说明图像质量几乎与原图一样好;在30-40dB之间通常表示图像质量的失真损失在可接受范围内;在20-30dB之间说明图像质量比较差;PSNR低于20dB说明图像失真严重。

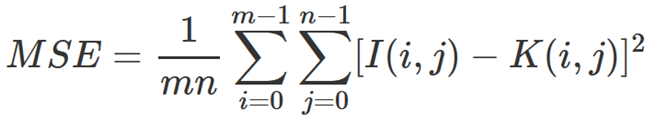

给定一个大小为m×n的灰度图 I 和噪声图 K,均方误差(MSE, Mean Square Error)公式如下:

定义:

其中,MAX2I 为图片可能的最大像素值,即B-bit的图像的MAX2I值为2B-1。一般地,针对 uint8 数据,最大像素值为255,;针对浮点型数据,最大像素值为1。

有三种方法来计算彩色RGB图像的PSNR:分别计算 RGB 三个通道的 PSNR,然后取平均值;或者计算RGB各个通道的均方差的均值,然后统一求PSNR;或者把RGB转化为 YCbCr,然后只计算 Y(亮度)分量的PSNR。

LPIPS

学习感知图像块相似度(Learned Perceptual Image Patch Similarity, LPIPS)也称为“感知损失”(perceptual loss),用于度量两张图像之间的差别。来源于CVPR2018的一篇论文《The Unreasonable Effectiveness of Deep Features as a Perceptual Metric》,该度量标准学习生成图像到Ground Truth的反向映射强制生成器学习从假图像中重构真实图像的反向映射,并优先处理它们之间的感知相似度。LPIPS 比传统方法(比如L2/PSNR, SSIM, FSIM)更符合人类的感知情况。LPIPS的值越低表示两张图像越相似,反之,则差异越大。

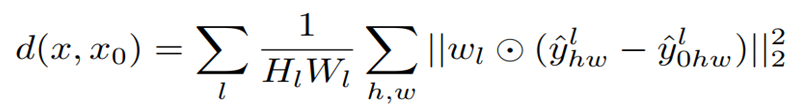

给定Ground Truth图像参照块x和含噪声图像失真块x0,感知相似度度量公式如下:

其中,d为x0与x之间的距离。从L层提取特征堆(feature stack)并在通道维度中进行单位规格化(unit-normalize)。利用向量wl来放缩激活通道数并计算L2距离。最后在空间上平均,在通道上求和。

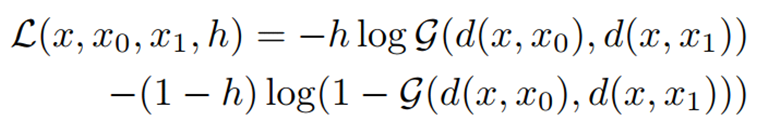

基于学习的相似度得分函数公式如下:

给定Ground Truth图像参照块x和含噪声图像失真块x0的距离d0、Ground Truth图像参照块x和含噪声图像失真块x1的距离d1,在顶部训练一个网络G(包含2个32通道FC-ReLU层、1通道FC层和sigmoid层)映射到得分h。